こんにちは!

現役パラレルワーカー フクコです。

前回の記事↓に続き

www.fukuko-parallel-work.com

来年の2月の試験に向けてE資格試験勉強中のため

E資格とは?の記事はコチラ↓

ゼロつくシリーズでおなじみ

オーライリーから出版されている

ディープラーニングの本格的な入門書でよくおススメされる

「ゼロからつくる Deep Learning」本

この本↑を毎日5ページずつコツコツこなすと

約2か月間で今年中に終了するので

来年のE資格試験までにこれで基礎力をつけることにしました。(^^)

ついつい私は何もないとだらけてしまうので(笑)

毎日5ページ終わった後の記録とまとめを書いていこうと思います。

と、まとめに入る前に…

やる気を出すためのコトバをシェアします!!(主に私のやる気を出すために 笑)

「この世にどうでもいい事なんてないと思うよ。

きっと、カナヲは心の声が小さいんだろうな。

指示に従う事も大切なことだけど。」

by炭治郎

私の大好きな「鬼滅の刃」から

炭治郎の名言です。

「何でもいい、どうでもいいの。」と無気力なカナヲへ

炭治郎のひとことですが、

炭治郎、きみ、ほれてまうやろ~!!(>ー<)笑

こういう、無邪気、ストレートに思いやりのコトバをかけられるの、

私、弱いんですよね~。無邪気ってコワい。笑

とにかく

自分の心の声に常に耳を傾けて

素直に自分の心のままに行動するのがイチバン!!

炭治郎、どうもありがとう! (^0^)

今日もやる気が出てきました!

よし!! 今日も頑張るぞ~! お~!!

というコトで、

私は、ゼッタイ来年E資格受かりたいので、素直に心のままに、今日もノルマはゼッタイこなします!笑

ではでは、いい加減まとめに入ります。笑

その前に本の目次の紹介です。

ゼロつくディープラーニングは、下記↓の合計8章で構成されています。

本の目次

- 1章 Python入門

- 2章 パーセプトロン

- 3章 ニューラルネットワーク

- 4章 ニューラルネットワークの学習

- 5章 誤差伝播法

- 6章 学習に関するテクニック

- 7章 畳み込みニューラルネットワーク

- 8章 ディープラーニング

ちなみに…

ゼロつくディープラーニングの第1章はPython入門のセクション(20ページ分)なので、

とりあえず今回私は飛ばし、第2章からまとめています。

現在は、第7章 畳み込みニューラルネットワークで~す。

第7章 畳み込みニューラルネットワーク つづき

第7章のテーマは、

畳み込みニューラルネットワーク(Convolutional Neural Network: CNN)。

7.7 代表的なCNN

特に重要な2つのネットワークを紹介。

1つめは、1998年に初めて提案されたCNNの元祖、LeNet。

2つめは、ディープラーニングが注目を集めるに至った2012年のAlexNet。

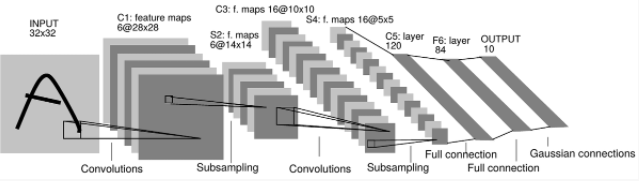

7.7.1 LeNet

LeNetは、初めてのCNN。

LeNetのネットワーク構成は、↓のとおり。

1.入力:32x32の画像

2.畳み込み層:5x5カーネルx6チャンネル

活性化関数: tanh

3.サブサンプリング層:2x2(重みつき平均値プーリング)、ストライド:2

活性化関数: sigmoid

4.畳み込み層:5x5カーネルx16チャンネル

活性化関数: tanh

5.サブサンプリング層:2x2(重みつき平均値プーリング)、ストライド:2

活性化関数: sigmoid

6.畳み込み層:5x5カーネルx120チャンネル

活性化関数: tanh

7.全結合層:120ユニットx84ユニット

活性化関数: tanh

8.出力:10次元ベクトル(各次元の出力確率)

LeNetは、

手書き数字認識を行うネットワークとして1998年に提案された。

「現在のCNN」とくらべると、

LeNetは、シグモイド関数を使用するのに対し、現在はReLU関数を使う。

さらに、

LeNetは、

サブサンプリングで中間データサイズの縮小を行うが、現在はMaxPoolingを使う。

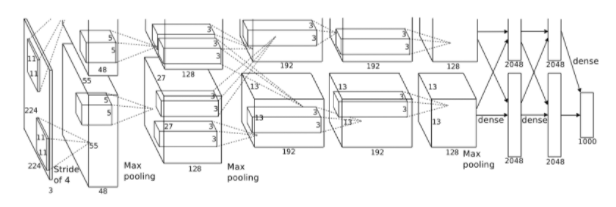

7.7.2 AlexNet

その後、20年経過して

AlexNetが、ディープラーニングの火付け役となった。

AlexNetは、

2012年に、

ImageNetコンペティションで優勝したトロント大学SuperVisionチームの開発したネットワーク。

AlexNetのネットワーク構成は、↓のとおり。

AlexNetでも、

畳み込み層とプーリング層を重ねて

最後に全結合層を経由して結果を出力する。

そこまではLeNetと変わらない。

LeNetとの違いは下記↓のとおり。

- ReLU関数を活性化関数とする。

- LRN(Local Response Normalization)という局所的正規化を行う層を用いる。

- Dropoutを使用する。

大量の並列計算を得意とするGPUが普及し、

大量の演算を高速に行うことが可能となる。

7.8 第7章 畳み込みニューラルネットワークのまとめ

- CNNは、これまでの全結合ネットワークに対して、畳み込み層とプーリング層が新たに加わる。

- 畳み込み層とプーリング層は、im2col(画像を行列に展開する関数)を用いるとシンプルで効率の良い実装になる。

- CNNの可視化により、層がふかくなるにつれて高度な情報が抽出されていく様子がわかる。

- CNNの代表的なネットワークには、LeNetとAlexNetがある。

今日のまとめ

ハイ、今日はここまで!!

ようやく、第7章が終了~!残るはあともう1章です!!先が見えてきました。(^^)

引き続き頑張りまっす。

最後まで読んでくださり、ありがとうございます!

フクコ

ディープラーニング入門書おススメ本

E資格とは?